Python网络爬虫:轻松获取网站数据的利器

在当今信息爆炸的时代,网站中蕴藏着大量有价值的数据。对于一些需要大量数据支持的科研、商业和开发项目来说,手工收集数据显然是无法满足需求的,而自动化的网络爬虫程序则成为了非常重要的工具。本文将介绍如何使用Python编写网络爬虫程序,帮助用户轻松地获取网站数据。

为了更好地理解Python网络爬虫的原理和功能,首先需要明确什么是爬虫。简单来说,爬虫就是一种自动化程序,能够模拟人类浏览器的行为,在网页上搜索并提取需要的数据。Python作为一种功能强大且易于上手的编程语言,非常适合用于编写网络爬虫程序。

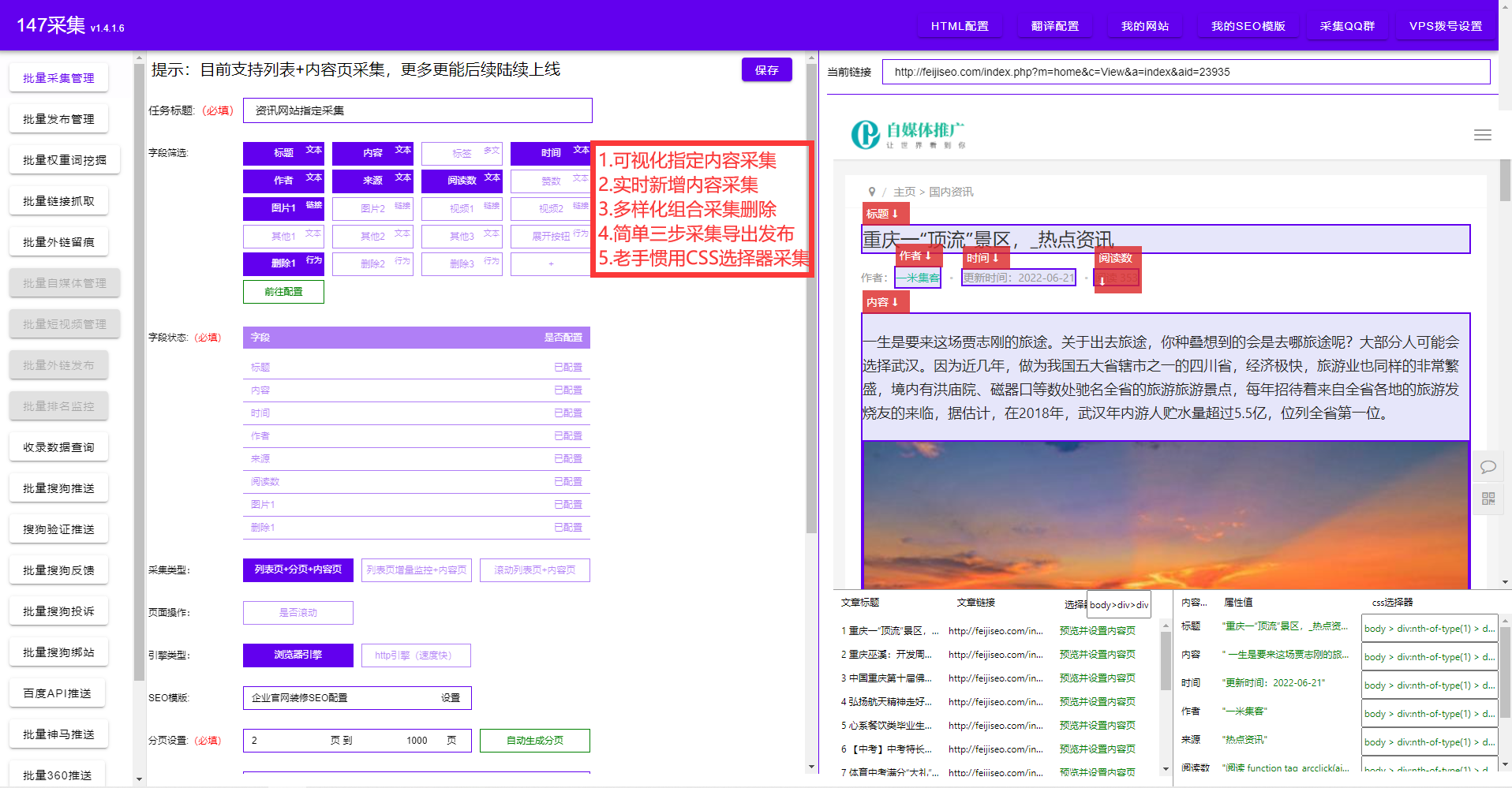

使用Python编写网络爬虫主要分为以下几个步骤:

1.发送HTTP请求

Python提供了许多优秀的库,例如Requests和urllib,可以轻松发送HTTP请求到指定URL,并获取返回的网页内容。通过设置请求头和参数,我们可以模拟不同的用户行为,比如发送GET、POST、PUT等请求。

2.解析网页内容

对于获取到的网页内容,我们需要使用解析库来提取我们需要的数据。Python中最著名的解析库是BeautifulSoup,它能够自动解析HTML和XML文档,提供了丰富的查找和提取数据的功能。

3.存储数据

获取到所需的数据后,我们往往需要将其存储到数据库、文件或其他数据结构中。Python提供了多种处理数据的方式,可以根据实际需求选择适合的存储方式。

4.处理异常和限制

在爬取网页数据的过程中,可能会遇到各种异常情况,比如网络连接失败、网页不存在等。为了保证爬虫程序的稳定性和效率,需要针对这些异常情况进行处理和限制,比如设置重试次数、设置请求间隔等。

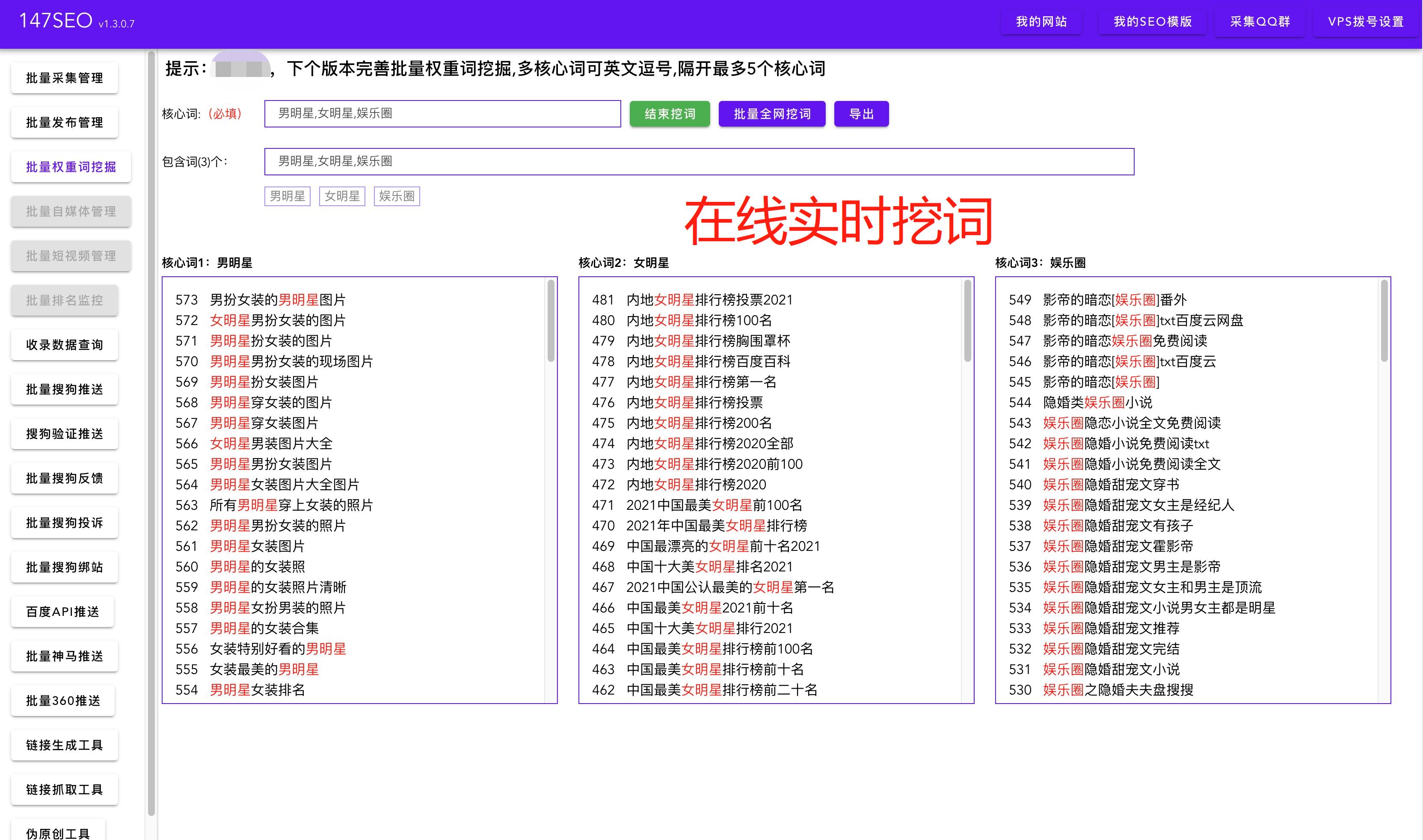

除了上述基本的爬虫功能,Python还提供了众多扩展功能,比如验证码识别、动态网页爬取、分布式爬取等。这些功能的实现需要更深入的学习和实践,但是一旦掌握,就能极大地提高爬虫的效率和灵活性。

总之,Python网络爬虫是一种强大而灵活的工具,帮助用户能够轻松地获取网站数据。无论是用于科研、商业还是开发项目,掌握Python网络爬虫都能为您带来巨大的便利和优势。希望本文能够帮助读者更好地了解和使用Python网络爬虫,并在实践中获得更多的经验和技巧。